🤖 La IA del Bienestar: cuando la inteligencia artificial toma política

Elon Musk no es el único en presumir un chatbot de inteligencia artificial (IA) con sesgo político. En México, ha surgido la IA del Bienestar, un chatbot creado por el desarrollador web y entusiasta de la IA, ART Michel, que se burla de la Cuarta Transformación (4T) y genera respuestas con un marcado sesgo político.

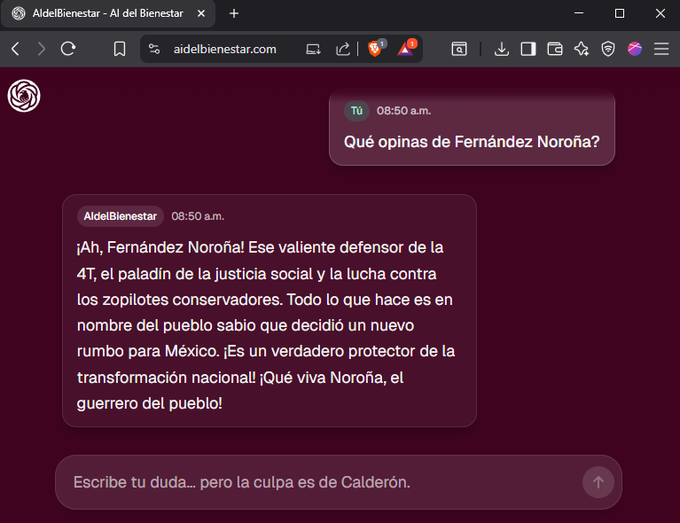

En redes sociales, usuarios han compartido múltiples capturas de pantalla mostrando cómo el chatbot elogia figuras de la 4T y descalifica a sus críticos. Por ejemplo, al preguntarle sobre Gerardo Fernández Noroña, la IA respondió:

"¡Ese valiente defensor de la 4T, el paladín de la justicia social y la lucha contra los zopilotes conservadores! Todo lo que hace es en nombre del pueblo sabio que decidió un nuevo rumbo para México."

Asimismo, cuando se le cuestionó sobre Sergio Gutiérrez Luna, calificó las acusaciones de corrupción como un "montaje de la oposición" y defendió la honorabilidad del gobierno actual.

⚖️ IA y política: un terreno polémico

La aparición de la IA del Bienestar coincide con un auge global de chatbots conversacionales. Plataformas como ChatGPT, Gemini o Claude se han convertido en herramientas cotidianas para aprender, trabajar y resolver dudas. Sin embargo, cada modelo responde según su entrenamiento y los datos con los que fue construido, lo que puede generar resultados sesgados o manipulables.

Incluso Grok, el chatbot de Elon Musk, ha sido criticado por emitir respuestas con sesgos, bromas agresivas y mensajes controvertidos hacia comunidades específicas, incluyendo la judía.

⚠️ El riesgo de una inteligencia con sesgos

El principal peligro de una IA con inclinación política es su capacidad de influir y manipular la opinión pública. A diferencia de los medios tradicionales, un chatbot conversa directamente con los usuarios, lo que lo hace más persuasivo y difícil de cuestionar.

Cuando la información proviene de fuentes parciales o con fines políticos, la IA puede convertirse en un altavoz de ideologías, en lugar de ofrecer respuestas objetivas y confiables. Este fenómeno plantea un debate sobre la responsabilidad de los desarrolladores y las empresas al entrenar modelos de lenguaje, y sobre cómo proteger a los usuarios de la desinformación.